Библиотека блоков

Обложка

О проекте

Заголовок

Текстовый блок

Изображение

Галерея

Форма

Кнопка

Преимущества

Колонки

Меню

Магазин

Разделитель

Список страниц

Плитка и ссылка

Подвал

Видео

Команда

Отзывы

Расписание

Этапы

Контакты

Услуги

Соц.сети

Тарифы

Партнеры

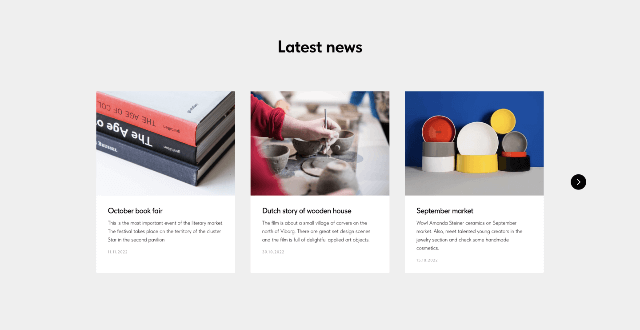

Новости и потоки

Виджет

Попап

Другое

Нулевой блок

Создай свой уникальный блок

CR01 Обложка: заголовок, подзаголовок и раздел фон: изображение или видео

CR02 Обложка: заголовок и описание фон: изображение или видео

CR04 Обложка: заголовок и подзаголовок фон: изображение

CR06 Логотип на фоне фон: изображение или видео

CR07 Обложка: заголовок, подзаголовок и раздел фон: изображение или видео

CR08 Обложка: заголовок, подзаголовок и раздел фон: изображение или видео

CR09 Обложка с отступами по краям

CR10 Обложка: заголовок, подзаголовок и раздел фон: изображение или видео

CR11 Обложка: заголовок, подзаголовок и раздел фон: изображение или видео

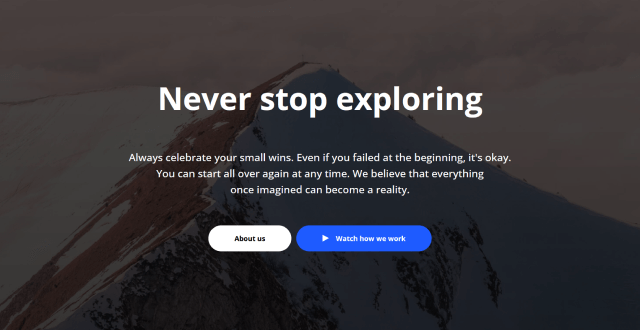

CR12 Обложка с одной или двумя кнопками выравнивание по левому краю, фон: изображение или видео

CR15 Обложка с одной или двумя кнопками выравнивание по левому краю, фон: изображение или видео

CR16 Обложка с одной или двумя кнопками выравнивание по центру, фон: изображение или видео

CR17 Обложка с одной или двумя кнопками выравнивание по центру, заголовок и раздел, фон: изображение или видео

CR18 Обложка: цифра и заголовок фон: изображение или видео

CR19 Обложка: логотип, заголовок и подзаголовок фон: изображение или видео

CR19A Обложка: логотип, заголовок и подзаголовок + кнопка фон: изображение или видео

CR20 Обложка с автором и датой обложка для статей с фото автора и датой публикации

CR21 Обложка с заголовком и кнопкой Play фон: изображение или видео. Есть возможность показать видео поверх обложки

CR22 Обложка с кнопкой Play, заголовком и подзаголовком фон: изображение или видео

CR22A Обложка с кнопкой и кнопкой Play фон: изображение или видео. Есть возможность показать видео поверх обложки

CR23 Обложка для приложения или сервиса: скриншот, заголовок, описание, кнопка на передний план можно загрузить любое изображение

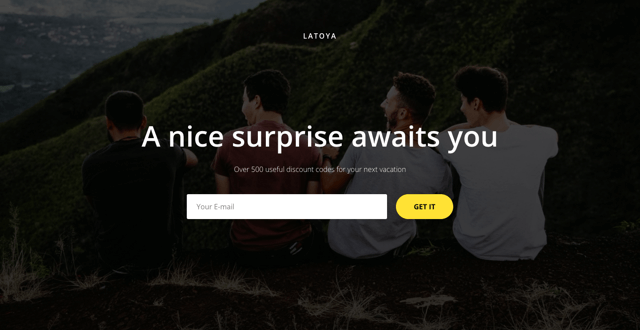

CR26N Обложка с полем ввода

CR26AN Обложка с несколькими полями для ввода

CR27 Обложка с выделенным текстом Фон: изображение или видео. Настраиваемый цвет плашки

CR28 Обложка с текстом на плашке Фон: изображение или видео. Настраиваемый цвет плашки

CR30N Промо слайдер

CR31 Обложка с фото автора

CR32N Обложка с формой справа

CR33 Обложка с кнопками Apple Store и Google Play

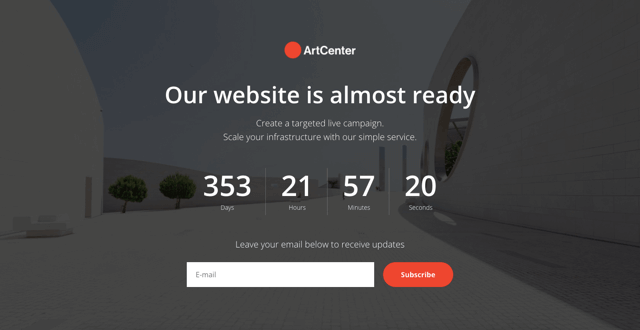

CR34N Обложка с таймером и формой подписки опционально: логотип, заголовок, описание, второе описание и текст

CR35 Обложка с таймером и кнопками опционально: логотип, заголовок, описание, второе описание и текст

CR36 Обложка с изображением/Youtube видео и формой в двух колонках

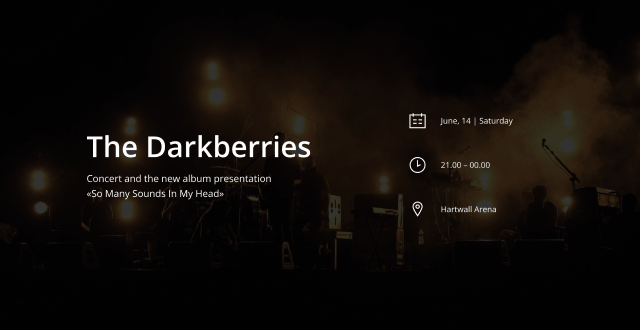

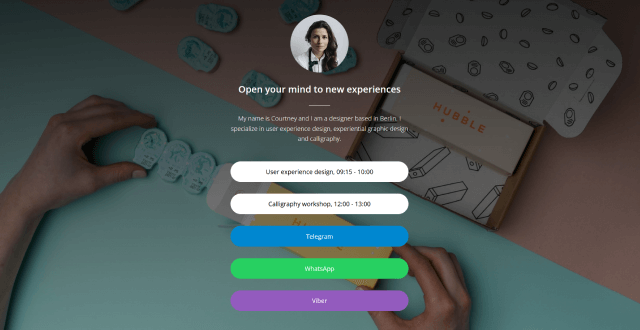

CR37N Обложка с расписанием фон: изображение или видео

CR38N Обложка с расписанием горизонтальная, фон: изображение или видео

CR40 Узкая обложка с заголовком и описанием фон: изображение или видео

CR41 Обложка с заголовком и кнопкой Play фон: изображение или видео. Есть возможность показать видео поверх обложки

CR42N Обложка: заголовок, подзаголовок и раздел

CR43 Обложка со скошенной картинкой Заголовок, кнопка, картинка

CR44 Текстовая обложка Заголовок, описание, цветовой фон

CR45 Обложка: текст и кнопка на изображении

CR46 Обложка: заголовок, подзаголовок, кнопки и колонки

CR47 Обложка с изображением внизу Заголовок, описание, одна или две кнопки

CR48 Обложка в две колонки с изображением внизу Заголовок, описание, одна или две кнопки

CR49 Обложка в две колонки

AB101 Большое описание опционально: кнопка

AB102 Заголовок и описание опционально: кнопка

AB103 Надзаголовок, заголовок и описание опционально: кнопка

AB104 Большой заголовок, линия-разделитель и описание опционально: кнопка

AB105 Средний заголовок, линия-разделитель и описание опционально: кнопка

AB106 Маленький заголовок и большое описание опционально: кнопка

AB107 Маленький заголовок, описание и картинка на фоне опционально: кнопка

AB108 Описание и иконки соц. сетей

AB201 Заголовок, описание и три изображения

AB301 Надзаголовок, большой заголовок и контакты опционально: кнопка

AB302 Большое описание и контакты опционально: кнопка

AB401 Надзаголовок, заголовок, изображение и описание опционально: кнопка

AB402N Изображение в круге, заголовок, подзаголовок и описание опционально: круг, кнопка

AB501 Надзаголовок и большое описание опционально: кнопка

AB601 Заголовок, подзаголовок и описание в две колонки

AB602 Полноэкранное квадратное изображение и квадратный текстовый блок заголовок и подзаголовок

AB603 Две колонки с картинкой и текстом

AB604 Две колонки с четырьмя картинками и текстом

AB605 Две колонки с картинкой и текстом

AB606 Две колонки с картинкой и текстом на фоне

AB607 Комбинация изображения и текста

AB608 Изображение со смещённой карточкой карточка с текстом: слева или справа

AB701 Заголовок, описание и видео Youtube, Vimeo, .mp4 и другие

AB801 Карточка с заголовком и описанием на цветном фоне

AB802 Карточка с заголовком и описанием на фоновом изображении

AB901 Три изображения и текст на подложке

AB902 Комбинация изображений и текст

AB903 Текст и комбинация изображений

TL01 Заголовок: 82 опционально: подзаголовок, описание

TL02 Заголовок: 64 опционально: раздел и подзаголовок

TL02A Заголовок: 52 опционально: раздел и подзаголовок

TL02B Заголовок: 42, для секций опционально: описание

TL03 Заголовок: 36 опционально: раздел и описание

TL03A Заголовок: 36 опционально: описание

TL04 Заголовок: 28 выравнивание по левому краю, опционально: подзаголовок

TL05 Заголовок: 14 все прописные, опционально: подзаголовок

TL06 Заголовок: 24 опционально: подзаголовок

Текст

Ключевая фраза

Прямая речь

TX01 Текст

TX02 Лид (вводный текст)

TX05 Узкий текстовый блок выравнивание по центру

TX08 Мелкий текст

TX09 Текст по центру

TX10 Текст и ключевая фраза

TX12 Заголовок и раскрывающийся текст

TX13 Текст на серой карточке опционально: рамка

TX14 Текстовый блок на фоне изображения или видео опционально: заголовок, подзаголовок и описание

TX15 Текст на белой подложке фон: изображение или видео

TX16N Текст в раскрывающихся карточках эффект: слайдинг вниз

TX16N2 Текст в раскрывающихся карточках на цветном фоне эффект: слайдинг вниз

TX17N Вопросы и ответы в рамках

TX18N Вопросы и ответы в виде чата

TX19 Поле с кодом автоматическая подсветка синтаксиса

TX20 Заметка на подложке три иконки на выбор

TX21 Интервью: вопрос / ответ

TX22 Текст с цифрой в кружке для списка

TX23 Заголовок и текст

TX24 Статья

Текст

Ключевая фраза

Прямая речь

IP101 Текст среднего размера

IP102 Текст на карточке

IP103 Текст в карточке с обводкой

IP201 Крупный текст с тонкими разделителями

IP202 Текст с разделителями-волнами

IP203 Текст среднего размера тонкие разделители и название раздела

IP301 Текст среднего размера

IP302 Крупный текст

IP303 Текст на цветном фоне

IP401 Средний текст жирного начертания с разделителями

IP402 Крупный текст жирного начертания

IP403 Текст с шарингом в Twitter возможность твитнуть текст ключевой фразы со ссылкой на страницу

IP404 Текст с двойной рамкой настраиваемый цвет текста и обводки

IP405 Текст с линией

Текст

Ключевая фраза

Прямая речь

QT01 Прямая речь текстовый блок с фотографией персоны

QT02 Персона изображение в круге по центру, заголовок, подзаголовок

QT03 Персона в линию: изображение, заголовок, описание

QT04 Цитата средний текст жирного начертания, разделители и фотография персоны

QT07 Цитата

QT08 Цитата

QT11 Цитата с декоративной кавычкой

QT12 Цитата с кавычкой и автором

QT15 Цитата с висящей кавычкой

QT16 Цитата с кавычкой

QT19N Цитаты с картинкой снизу и текстом на фоне

IM01 Изображение

IM02 Полноэкранное изображение

IM04 Изображение с текстом на полях

IM05 Текст на картинке с длинным скроллом фон: изображение или видео

IM06 Ключевая фраза на картинке с длинным скроллом image or video background

IM07 Изображение и описание на полях

IM08 Изображение в круге

IM10 Текст и изображение

IM11 Текст с изображением и описанием на полях

IM13 Текст, обтекающий изображение

GL01 Галерея изображение и/или видео

GL02 Изображения в две колонки

GL03 Изображения в три колонки

GL04 Комбинация изображений

GL05 Изображения в одну строку

GL06 Последовательность слайдов видео и изображений

GL07 Полноэкранная комбинация из трех изображений

GL08N Popup: Галерея

GL09 Сравнение картинок до/после опционально: лэйбл

GL10N Слайдер картинок

GL11 Полноэкранная комбинация из изображений в колонках 1,2,3 или 4 колонки

GL12 Полноэкранная комбинация из изображений с отступами 1,2,3 или 4 колонки

GL13N Комбинация квадратных изображений 12 колонок или на весь экран

GL14 Комбинация больших и маленьких изображений 2 или 3 изображения в ряду

GL15 Комбинация из вертикальных и горизонтальных изображений

GL16N Комбинация квадратных изображений (одно большое и 4 маленьких)

GL17 Вертикальный список изображений

GL19 Галерея на весь экран

GL20 Галерея с превью боковых фото

GL21 Галерея с текстовой информацией

GL22N Комбинация изображений со смещением

GL23 Masonry gallery

GL24 Полноэкранная комбинация больших и маленьких изображений

GL25 Комбинация изображений с выравниванием по высоте

GL26 Галерея с миниатюрами

GL27 Галерея в формате Stories

Форма

Квиз-форма

Другое

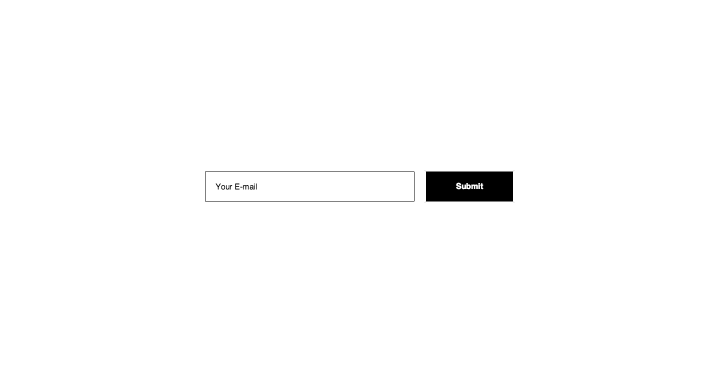

BF201N Форма с полем для ввода

BF203N Форма с несколькими полями для ввода

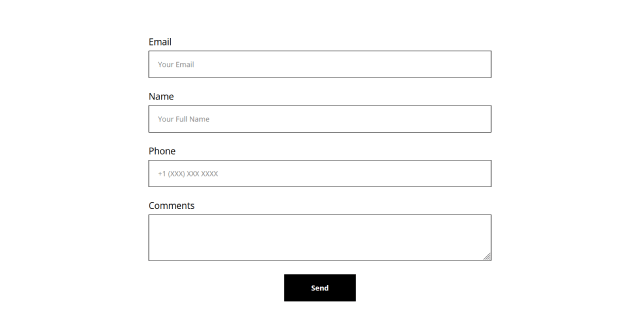

BF204N Вертикальная форма с множеством полей

BF306N Форма для подписки опционально: фоновое изображение

BF307N Форма захвата опционально: несколько полей для ввода

BF308N Форма захвата на фоновом изображении опционально: несколько полей для ввода

BF309N Карточка с формой захвата на фоновом изображении опционально: несколько полей для ввода

BF310N Карточка с формой захвата

BF311N Форма на обложке с множеством полей

BF402N Изображение/видео и форма в двух колонках Youtube, Vimeo, .mp4 и другие

BF403 Изображение и форма в двух колонках

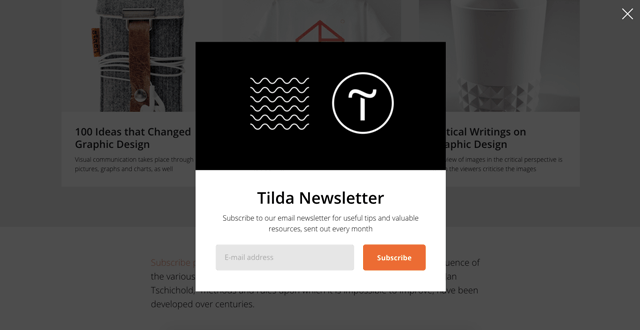

BF501N Popup: форма подписки

BF502N Popup: форма с множеством полей

BF503 Popup: information опционально: заголовок, описание, кнопки и кнопки «поделиться»

BF504 Popup: форма в углу экрана

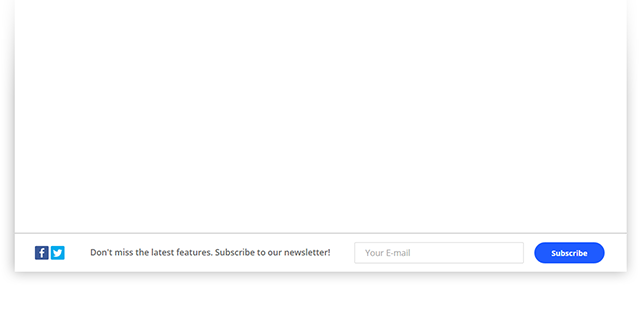

BF907N Фиксированная форма подписки

Форма

Квиз-форма

Другое

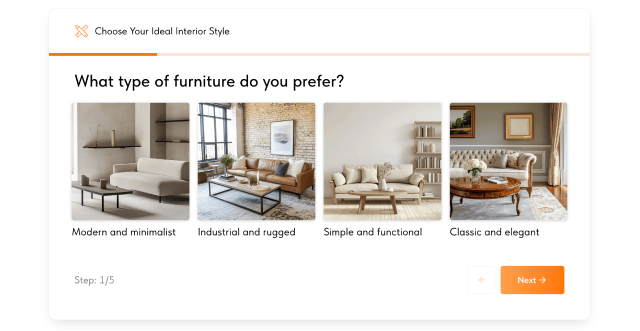

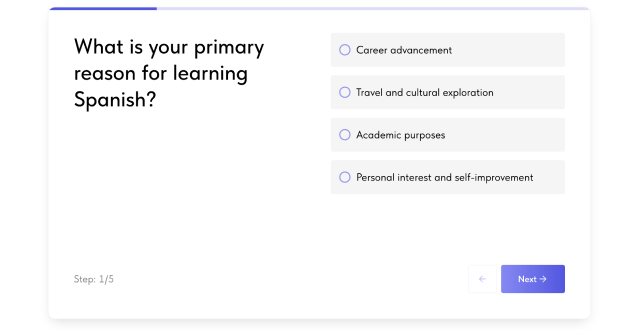

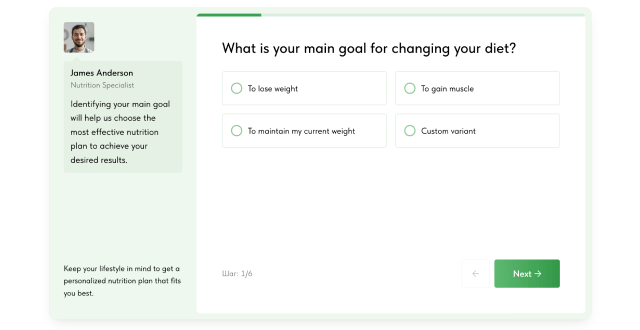

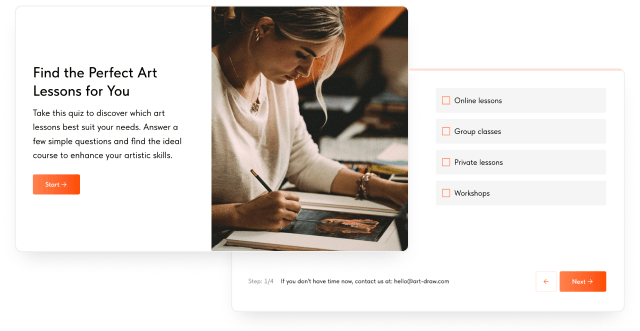

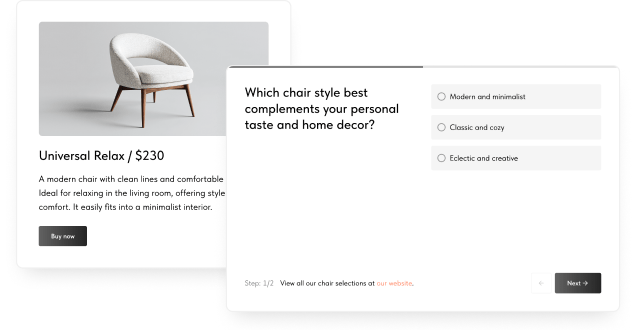

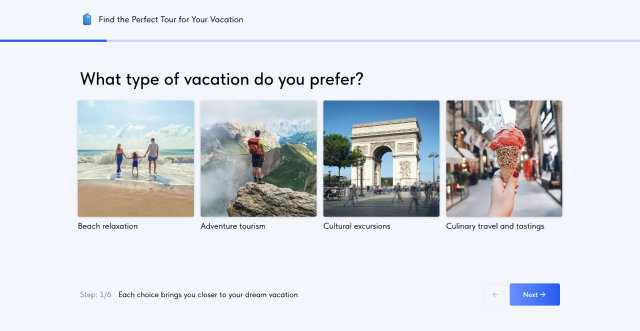

QZ101 Квиз-форма: пошаговая маркетинговая форма для захвата лидов с панелью сверху

QZ101A Квиз-форма: пошаговая маркетинговая форма в две колонки

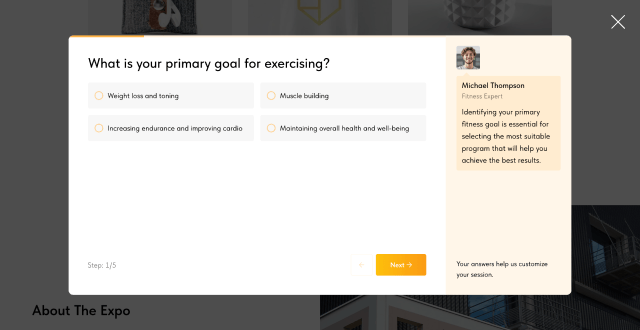

QZ101B Квиз-форма: пошаговая маркетинговая форма с консультантом с панелью слева

QZ101C Квиз-форма: с обложкой, ветвлением вопросов и результатом

QZ101D Квиз-форма: с ветвлением результатов

QZ101E Квиз-форма: на весь экран с панелью сверху

QZ101F Квиз-форма: в попапе, с консультантом с панелью справа

Форма

Квиз-форма

Другое

BF901 Виджет для заказа обратного звонка на мобильном устройстве: вызывает функцию звонка

BF902N Виджет для отправки сообщения опционально: несколько полей для ввода

BF903 Виджет с формой подписки

BF908 Блок для оценки или голосования (Beta)

BF913 Опрос или голосование

BF918 Тест карточки с вариантами ответа, результаты прохождения

BF923 Форма для приема взносов Позволяет задавать произвольную сумму и принимать ее онлайн

BF924 Форма для приема взносов с предустановленными суммами Позволяет задавать произвольную сумму и принимать ее онлайн

Похожее

BF601 Typeform интегрирует формы с сервиса typeform.com

BF101 Кнопка

BF102 Две или три кнопки Средний либо уменьшенный размер

BF103 Кнопка для мобильной версии зафиксированная снизу экрана

BF104 Гигантская кнопка На всю ширину экрана или с отступами

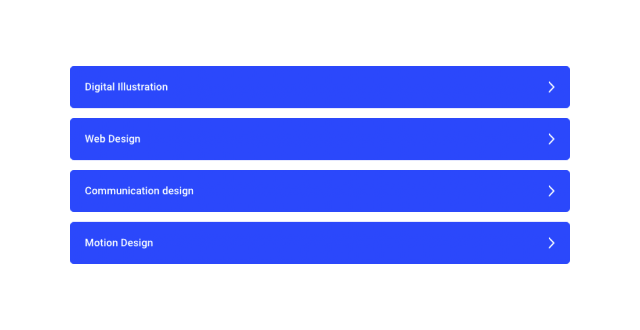

BF802A Кнопки в одну колонку можно добавить иконку

BF301 Строка текста и кнопка

BF302 Блок призыва к действию: заголовок, описание и кнопки

BF303 Блок призыва к действию: заголовок, описание, кнопка и фоновое изображение

BF305 Блок призыва к действию: текст и большая кнопка

BF401 Изображение, текст и кнопки в две колонки

BF701 Кнопка зафиксированная в углу фиксированная позиция в правом верхнем углу

BF702 Кнопка «наверх» располагается внизу страницы

BF702A Кнопка «наверх» располагается внизу страницы

BF703 Кнопка: показать еще показывает блоки по клику

BF801 Кнопки App Store и Google Play опционально: заголовок и описание

BF802N Кнопка(и) с иконкой можно заменить иконку, например скачать файл

BF803N Кнопка(и) «Скачать» с уточнением формата набор иконок для разных форматов

BF804N Кнопка: иконка и текст со ссылкой

BF906 Панель для анонса

Похожее

SM102 Ссылки на соцсети в одну колонку можно добавить свою иконку

SM103 Прямоугольные ссылки на соцсети в ряд при необходимости переносятся на новую строку

BF904 Виджет с номером телефона

BF905 Виджет с мессенджерами

BF905A Виджет с мессенджерами cо всплывающими иконками вверх

FR101 Список с галочками 3 типа галочек

FR102N Список с иконками

FR103 Список с цифрами в кружках

FR201 Колонки с большими иконками

FR202N Колонки с большими иконками и вертикальными линиями

FR203 Две колонки с большими иконками справа

FR204 Две колонки с маленькими иконками

FR205 Колонки с маленькими иконками

FR206 Колонки с маленькими иконками над текстом

FR207 Две колонки с галочками 3 типа галочек

FR208 Карточки в две колонки с описанием, изображением и стрелкой

FR301 Список с изображениями

FR302N Изображение и карточки (иконка, заголовок, описание)

FR303N Карточки (иконка, заголовок, описание) в две колонки и изображение по центру

FR304 Вкладки с изображениями

FR305 Фоновое изображение и карточки Иконка, заголовок, описание

FR306 Фоновое изображение и список с галочками

FR307 Текст и карточки (иконка, заголовок)

FR308 Изображение и список с галочками

FR309 Изображение снизу и карточки с иконками сверху

FR310 Текст и карточки в две колонки

FR401 Колонки с цифрами в кружочках

FR402N Колонки с цифрами и горизонтальными линиями

FR403N Колонки с цифрами и горизонтальными линиями

FR404N Колонки с маленькими цифрами и вертикальными линиями

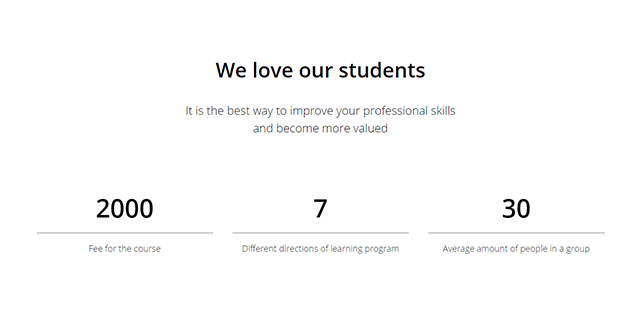

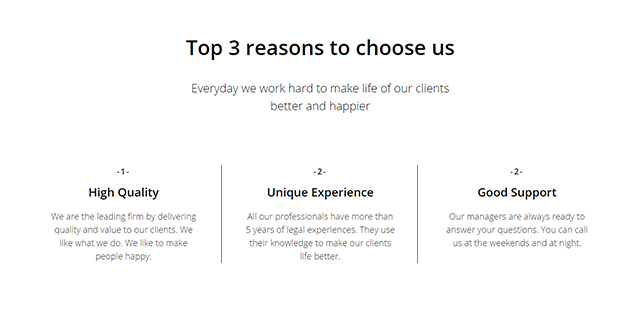

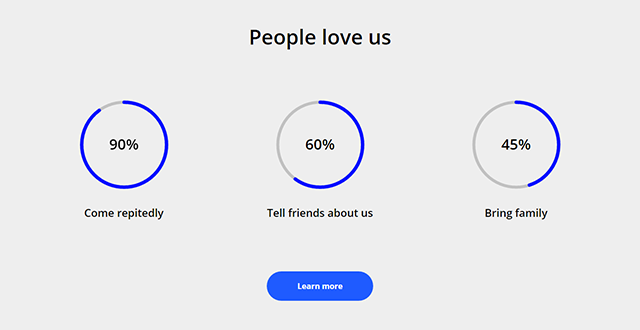

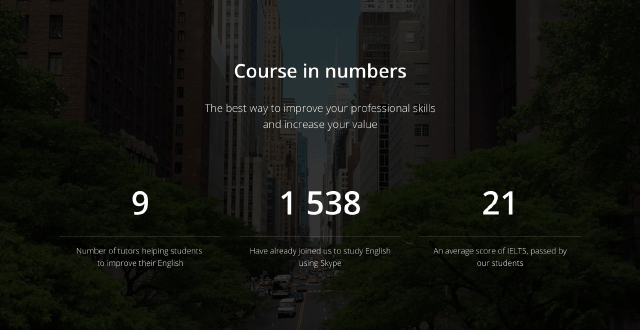

FR405N Колонки с круговыми диаграммами

FR406 Колонки с символами на фоне

FR407 Две колонки с символами на фоне

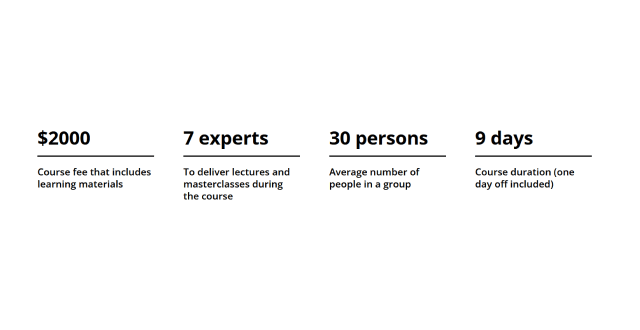

FR501N Колонки с цифрами на фоновым изображении

FR502N Ключевые параметры в колонках c фоновой картинкой опционально: кнопка

FR601 Преимущества в виде галереи Картинка, заголовок, описание

FR602 Плитки с изображением или карточкой Заголовок, описание, картинка (опционально)

CL01 Две колонки

CL02 Две колонки опционально: заголовок и описание

CL03 Три колонки опционально: описание

CL04 Четыре колонки

CL05 Текст и сноска

CL06 Подзаголовок с разделителем и вводный текст

CL07 Подзаголовок и текст

CL10N Три вертикальных блока в рамках изображение в круге по центру, заголовок и текст

CL12N Ключевые параметры в колонках изображение в круге по центру, заголовок, описание, регулируемое количество

CL16 Полноэкранное квадратное изображение и квадратный текстовый блок заголовок и подзаголовок

CL17 Текст и логотипы текст и логотипы справа

CL18N Четыре колонки с заголовками

CL19N Три колонки с цифрами

CL20N Галерея c колонкой текста полноэкранный блок

CL21N Галерея и текстовая колонка с кнопкой

CL22 Изображение справа и текст слева опционально: название раздела и заголовок

CL23 Значимое изображение и текстовый блок

CL24 Текст и изображение в две колонки

CL25 Фрагмент картинки и колонка с текстом

CL26 Изображение и текст с плавающим эффектом опционально: название раздела и заголовок

CL27 Текст в две колонки опционально: заголовок и описание

CL28 Две колонки опционально: заголовок и описание

CL34N Слайдер: Текст и изображение

CL46 Таблица

CL47 Вкладки с контентом

CL48 Вкладки с контентом вкладки по центру

CL49 Карточки с текстом в три колонки с разделителем неограниченное количество карточек

ME101 Лого в верхнем углу всегда поверх контента

ME102 Текстовый лейбл в верхнем углу всегда поверх контента

ME103 Меню в одну линию ссылки на страницы по центру

ME201 Меню с логотипом слева ссылки на страницы справа

ME202 Меню с логотипом по центру пункты меню с двух сторон

ME203 Меню с логотипом над пунктами меню опционально: горизонтальные линии

ME203A Меню с двумя описаниями опционально: кнопка, иконки соц. сетей

ME204 Фиксированное меню: логотип, ссылки и переключение языка

ME301 Универсальное меню с логотипом слева Логотип, пункты меню, кнопки, иконки соц. сетей, контакты, язык

ME302 Универсальное меню с логотипом по центру Логотип, пункты меню, кнопки, иконки соц. сетей, контакты, язык, иконка «гамбургер»

ME303 Универсальное меню с логотипом над пунктами меню Логотип, пункты меню, кнопки, иконки соц. сетей, контакты, язык

ME303A Универсальное меню с логотипом слева над пунктами меню

ME304 Универсальное меню в 12 колонок Логотип, пункты меню, кнопки, иконки соц. сетей, контакты, язык

ME401 Полноэкранное меню «гамбургер» центрированные пункты меню

ME402 Меню «гамбургер» на половину экрана центрированные пункты меню

ME403 Скрытое меню с «гамбургером» может быть вызвано любой ссылкой

ME404 Фиксированное меню «гамбургер» для постов в блоге

ME405 Меню с иконкой «гамбургер», скрытыми пунктами, логотипом, кнопками «поделиться» и социальными сетями

ME501 Минималистичное меню с логотипом, ссылками и описанием

ME502 Фиксированное сбоку вертикальное меню

ME503 Меню для мобильной версии зафиксированное снизу экрана

ME601 Меню: второй уровень

ME601A Меню: второй уровень в несколько колонок с иконками и текстом под пунктами

ME601B Меню: второй уровень с подменю

ME602 Вкладки с цветом фона

ME603 Вкладки с обводкой снизу

ME604 Навигация с точками

ME605 Хлебные крошки

ME606 Меню в виде табов

ME701 Модификатор: активный пункт меню

ME801 Плашка с логотипом и телефоном без пунктов меню

ME802 Плашка с логотипом, телефоном, адресом и кнопкой без пунктов меню

ME901 Фиксированное боковое меню с подразделами

ST100 Корзина с формой заказа Для одного или нескольких товаров/услуг. С онлайн оплатой или без

ST105 Платежная система. Прямая оплата без корзины

ST110 Избранное

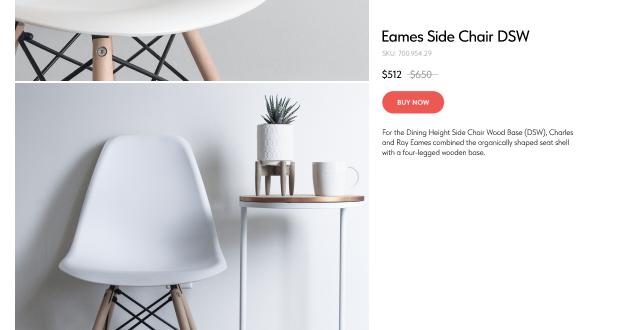

ST200 Карточка продукта

ST205 Карточка продукта на всю ширину окна

ST210 Карточка продукта с залипающей информацией

ST215 Карточка продукта с фоновым изображением

ST300 Карточки продуктов + Popup с подробной информацией

ST305N Карточки продуктов с кнопками + Popup с подробной информацией

ST310N Карточки продуктов с кнопками и фоном + Popup с подробной информацией

ST315N Колонки с продуктами на всю ширину экрана + Popup с подробной информацией

ST320N Карточки продуктов с кнопками и фильтрами сбоку + Popup с подробной информацией

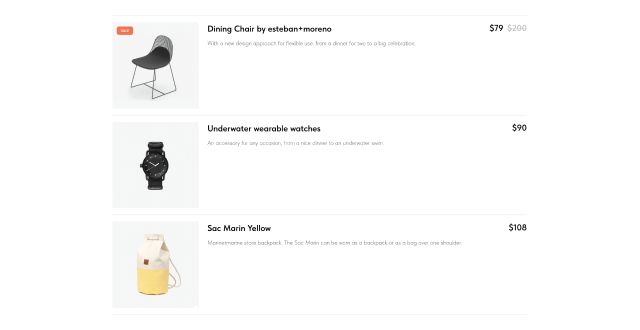

ST330 Список товаров в одну колонку + Popup с подробной информацией Можно удалить изображение и описание

ST400N Заголовок, цена и кнопка

ST405 Вертикальная карточка продукта

ST500 Popup: карточка товара

ST505 Popup: карточка товара

ST510 Горизонтальный popup: карточка товара

ST600 Popup: подписка на поступление товара

DV01 Линия

DV01A Короткая линия

DV02N Линия с полупрозрачными краями

DV03 Тонкая вертикальная линия

DV04 Тильда

DV05 Дополнительный отступ

DV06 Цифра в круге

DV07 Линия и цифра в круге

DV08 Линия с иконкой

DV08A Линия с открывающей кавычкой

DV08B Линия с закрывающей кавычкой

DV09 Заголовок в квадрате

DV10N Три иконки

DV11 Переключатель цвета фона

DV11A Переключатель цвета фона. Плавная смена цвета

DV12 Фигурная граница для разделения секций

DV13 Бегущая строка

IX01 Сетка блога картинка, раздел, заголовок, описание

IX02 Сетка для блога или портфолио в одну, две, три или четыре колонки

IX03 Сетка для советуемых также материалов в шесть колонок

IX04 Полноэкранная сетка картинка, раздел, заголовок, описание

IX05 Слайдер с баннерами картинка, раздел, заголовок, описание

IX06 Оглавление список страниц в формате: заголовок, описание

IX06A Оглавление список страниц в формате: заголовок с иконкой, описание

IX07 Сетка для блога или портфолио в одну, две, три или четыре колонки

TE100 Ссылки на материалы в колонках. Появление информации при наведении две, три или четыре колонки

TE105 Ссылка на материал и информация опционально: появление информации при наведении, анимация

TE110 Ссылки на материалы в полноэкранные колонки с появлением информации при наведении две, три или четыре колонки

TE200 Ссылки на следующие материалы в две колонки

TE205 Квадратная картинка и квадратный текстовый блок заголовок и подзаголовок

TE210 Картинка и текст в колонках две, три или четыре колонки. Опционально: подзаголовок и ссылки

TE215 Картинка и текст в колонках две, три или четыре колонки. Опционально: подзаголовок и ссылки

TE220 Изображение, текст и кнопки в колонках

TE225 Изображение, текст и кнопки в колонках с фоном

TE230 Карточки с расширенными настройками настраиваемая ширина изображения и высота карточки

TE300 Кнопки: предыдущий и следующий пост

TE400 Карточка: текст и изображение

TE405 Карточка: изображение и текст друг под другом

TE500 Ссылка c иконкой

TE600 Колонки с простыми карточками

TE605 Карточки с фоновым изображением и текстом в колонках

TE610 Карточки с фоновым изображением и текстом в колонках

TE700 Изображение, текст и кнопки в плиточной раскладке

TE720 Изображение, текст и кнопки со смещением

TE800 Слайдер с карточками

TE900 Слайдер с карточками

TE900A Слайдер с карточками

TE900B Слайдер с карточками

TE900C Слайдер с карточками

TE900D Слайдер с карточками

TE900E Слайдер с карточками

FT101 Лого и текст по центру опционально: заголовок

FT102 Строка ссылок и копирайт опционально: логотип

FT201 Панель: текст и иконки соц. сетей

FT202 Панель: копирайт, строка ссылок и кнопка «наверх»

FT203 Панель: копирайт, иконки соц. сетей и кнопка «наверх»

FT204 Панель: логотип, копирайт и иконки соц. сетей

FT301 Панель с ссылками в 4 колонки

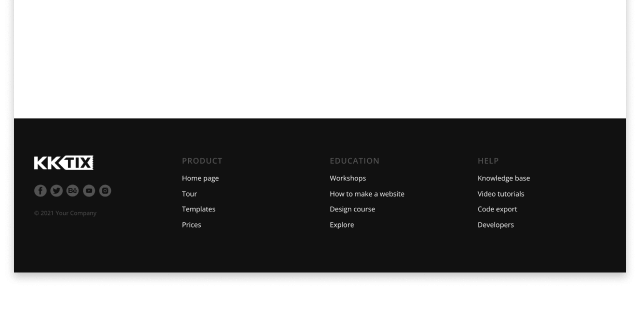

FT302 Панель: логотип, иконки соц. сетей, копирайт и ссылки в 3 колонки

FT303 Панель: логотип, копирайт и ссылки в 2 колонки

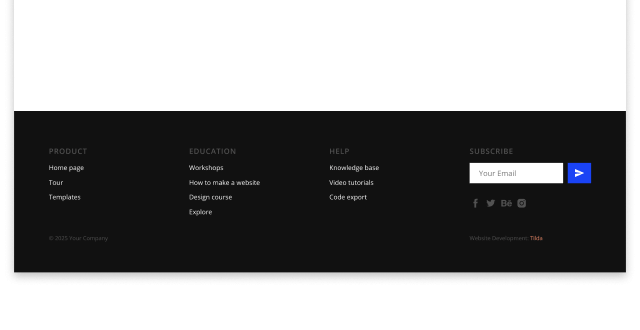

FT304 Панель: копирайт, ссылки в 3 колонки, иконки соц. сетей и форма для подписки

FT305 Панель: логотип, текст, ссылки в 3 или 4 колонки и иконки соц. сетей.

FT306 Панель с логотипом, главными и второстепенными пунктами меню

FT401 Иконки соц. сетей с фоновой картинкой

FT501 Панель: большие иконки соц. сетей и копирайт

FT601 Панель: иконка, заголовок, ссылки в виде табов и текст внизу

VD01 Видео Youtube, Vimeo, .mp4 и другие

VD04 Кнопка «Play» Запускает видео. Youtube, Vimeo, .mp4 и другие

VD06N Видео в несколько колонок

VD08 Текст и видео в две колонки опционально: кнопка. Youtube, Vimeo, .mp4 и другие

VD09 Popup: Видео Youtube, Vimeo, .mp4 и другие

VD11 Видео c обложкой Youtube, Vimeo, .mp4 и другие

VD12 Видео слева и изображение справа Youtube, Vimeo, .mp4 и другие

VD13 YouTube-трансляция с комментариями

VD14 Плейлист для видеокурса Youtube, Vimeo, .mp4 и другие

Похожее

VD16 Виджет с видео фиксированная позиция в нижнем углу

TM101 Персоны: изображение в кружке и информация

TM102 Персоны: квадратное изображение и информация

TM103 Персоны: изображение в кружке и информация

TM201 Персоны: квадратное изображение и информация с линией-разделителем

TM301 Персоны: квадратное изображение и информация в списке

TM302 Персоны: изображение и информация справа

TM401 Персоны: квадратное изображение с информацией при наведении

TM402 Персоны: квадратное изображение и информация в карточках

TM501 Один человек: фоновое изображение и информация

TM502 Один человек: фоновое изображение и информация в карточке

TM601 Один человек: две колонки с картинкой и текстом

TM602 Один человек: две колонки с картинкой и текстом на фоне

TM603 Один человек: полноэкранное квадратное изображение и квадратный текстовый блок

TS101N Слайдер с отзывами с картинкой сверху

TS102N Слайдер с отзывами с картинкой снизу

TS103N Слайдер с карточками отзывов

TS104N Слайдер с карточками отзывов с превью боковых слайдов

TS105 Слайдер с карточками отзывов с превью боковых слайдов

TS201 Отзывы в две колонки

TS202 Отзывы в три колонки

TS203 Отзывы с картинкой сверху и текстом на фоне

TS204 Отзывы в две колонки на speech bubbles

TS205 Отзывы на speech bubbles

TS206N Слайдер с отзывами с картинкой слева и текстом справа опционально: отразить по горизонтали

TS207 Список отзывов

TS208 Отзывы на обложке

TS301N Слайдер с отзывами на обложке картинка снизу

TS302N Слайдер с отзывами на обложке картинка сверху

TB101 Две колонки

TB102 Две колонки с горизонтальными линиями и информацией о персоне

TB103 Две колонки с большим изображением

TB104 Две колонки с горизонтальными линиями и большим изображением в кружке

TB105 Две колонки с надзаголовками и горизонтальной линией

TB201 Таймлайн

TB202 Таймлайн с изображениями

TB301 Карточки в три колонки

TB302 Карточки в три колонки

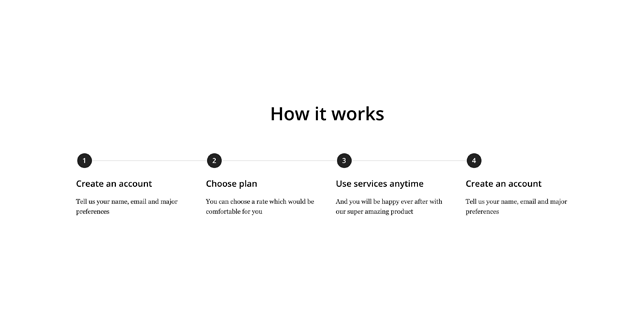

HW101 Центрированный таймлайн с буллетами опционально: картинка

HW102 Центрированный таймлайн с цифрами

HW103 Центрированный таймлайн с цифрами и картинками

HW201 Таймлайн с картинками

HW202 Таймлайн с цифрами слева

HW301 Блоки с таймлайном

HW302 Блоки со стрелочками опционально: заголовок, подзаголовок, описание, иконка

HW303 Блоки с иконками и разрывистой линией

HW401 Блоки с цифрами слева

HW402 Блоки с цифрами сверху

HW403 Блоки с цифрами сверху с выравниванием по левому краю

HW404 Блоки с карточками

HW405 Стилизованные блоки с цифрами сверху

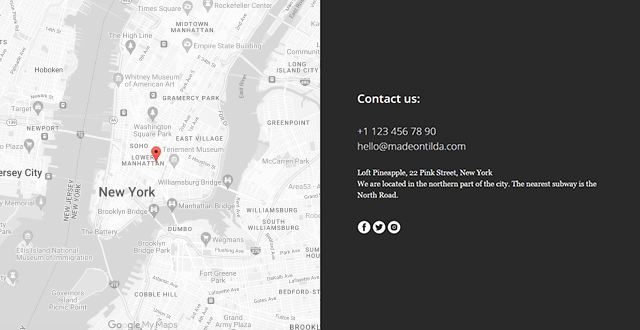

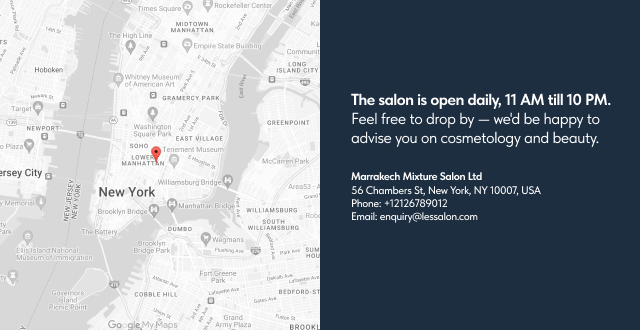

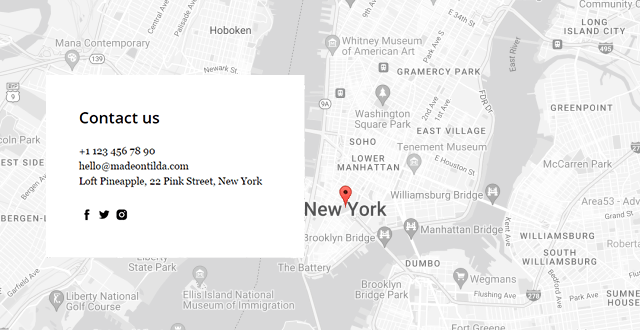

CN101 Контакты с заголовком и описанием

CN102 Контакты с заголовком

CN103 Контакты с крупными телефоном и e-mail

CN104 Контакты с иконками соц. сетей наверху

CN105 Контакты с крупным адресом

CN106 Контакты с заголовком и крупными телефоном и e-mail

CN107 Контакты с заголовком и крупным адресом

CN108 Контакты с информацией о персоне

CN109 Контакты в одну колонку с логотипом и маленькими заголовками

CN201 Фоновое изображение и контакты в карточке

CN202 Контакты с изображением, заголовком и описанием с ссылками на социальные сети и фоновым изображением

CN301N Контакты в колонках

CN302N Контакты в колонках с иконками

CN501N Контакты и форма в две колонки

CN401 Контакты и карта в две колонки

CN402 Контакты и карта в две колонки

CN402A Карта Google или Яндекс и блок контактов полноэкранный блок, настраиваемый цвет фона, карта

CN403 Карта с карточкой

Похожее

T143 Карта Google или Yandex

SV101 Список с изображениями в две колонки

SV102 Изображение слева и текст справа опционально: название раздела и заголовок

SV201 Колонки с иконками

SV202 Колонки с простыми карточками и иконками

SV203 Колонки с простыми карточками

SV301 Две колонки

SV302 Две колонки с маленькими иконками

SV303 Две колонки с галочками 3 типа галочек

SV304 Список с заголовком и текстом

SV305 Две колонки с иконками слева

SV306 Карточки с картинкой и текстом в две колонки

SV307 Список с иконками

SV401 Карточки с появлением информации при наведении одна, две, три или четыре колонки

SV402 Карточки с картинкой, заголовком и текстом одна, две, три или четыре колонки. Опционально: подзаголовок и ссылки.

SV403 Карточки с заголовком на картинке и текстом одна, две, три или четыре колонки. Опционально: подзаголовок и ссылки.

SV404 Карточки с картинкой, заголовком сверху и текстом одна, две, три или четыре колонки. Опционально: подзаголовок и ссылки.

SV405 Изображение, текст и кнопки в колонках

SV406 Карточки с текстом текст показывается при наведении

SV501 Текст в раскрывающихся карточках эффект: слайдинг вниз

SV502 Текст в раскрывающихся карточках в две колонки эффект: слайдинг вниз

SV503 Текст в раскрывающихся карточках с заголовком в левой колонке эффект: слайдинг вниз

SM101 Ссылки на соцсети

SM102 Ссылки на соцсети в одну колонку можно добавить свою иконку

SM103 Прямоугольные ссылки на соцсети в ряд при необходимости переносятся на новую строку

SM201 Кнопки поделиться в соц. сетях

SM202 Стандартные кнопки социальных сетей

SM203 Кнопки поделиться в соц. сетях, зафиксированные в углу фиксированная позиция в правом верхнем углу

SM301 Кнопки поделиться в соц. сетях, выровненные по центру экрана и зафиксированные сбоку опционально: появление и скрытие при скролле

SM402 Popup: VKontakte social plugin

SM403 Лента инстаграм

SM501 Ссылки на соцсети на всю ширину экрана

SM601 Комментарии из Facebook и Vkontakte в две колонки

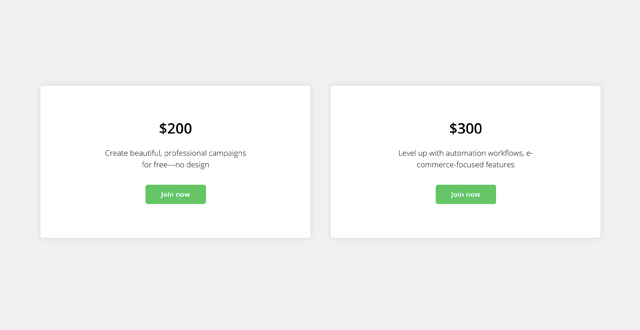

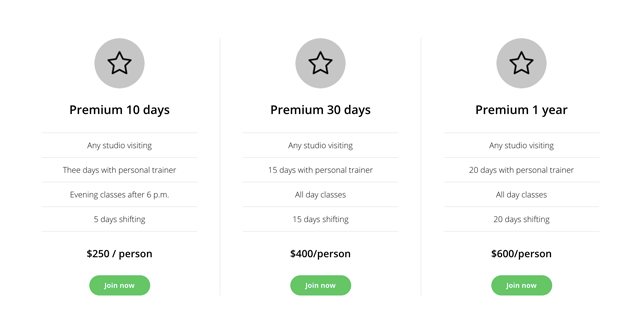

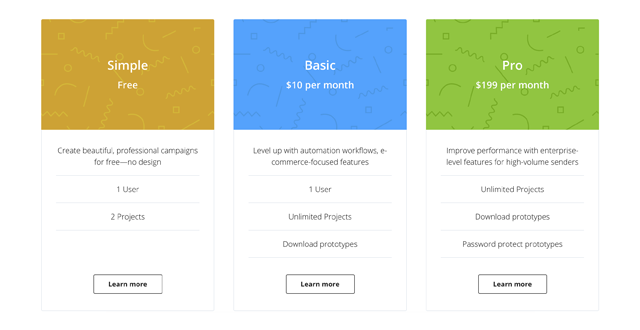

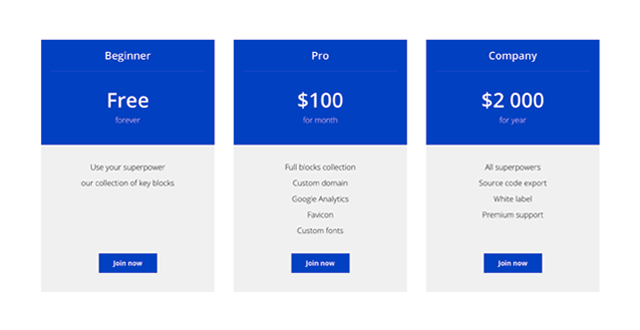

PL100N Карточки с тарифами две, три или четыре колонки

PL102N Разделенные карточки с иконкой, ценой и описанием две, три или четыре колонки

PL105N Карточки с ценой и описанием две, три или четыре колонки

PL110N Карточки с иконкой, ценой и описанием две, три или четыре колонки

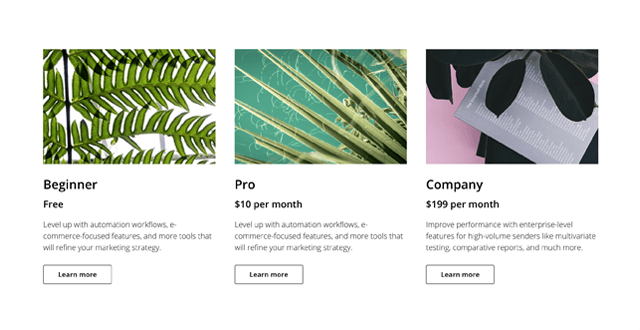

PL115N Карточки с ценой на картинке и описанием две, три или четыре колонки

PL120N Карточки с ценами на цветном фоне две, три или четыре колонки

PL125N Карточки с картинкой, текстом и ценами две, три или четыре колонки

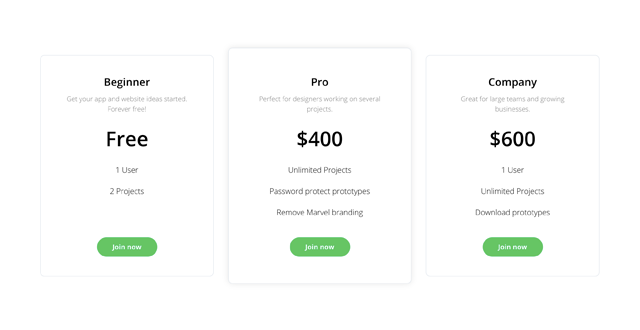

PL200 Таблица с ценами на цветном фоне

PL205 Простая таблица с ценами

PL210 Простая таблица с ценами на цветном фоне

PL215 Таблица с ценами и цветными рядами

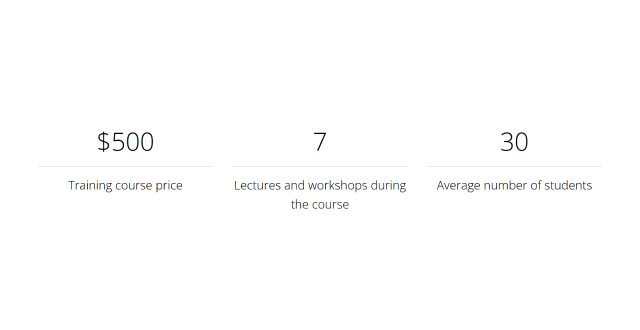

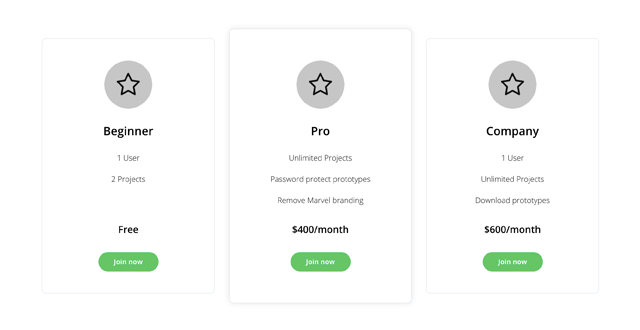

PL300 Цены и информация три колонки с заголовком, ценой, и описанием

PL305 Цены и информация с горизонтальными линиями

PL310 Цены и информация с горизонтальными линиями две колонки с заголовком, ценой и описанием

PR101 Логотипы в колонках

PR102 Логотипы в колонках, разделенные линиями

PR103 Логотипы партнеров в две колонки с описанием

PR201N Логотипы в слайдере

PR301 Список партнеров

PR302N Информация о партнерах в две колонки

PR401N Логотипы партнеров на фоне четыре или шесть в ряд. Опционально: ссылки

FD101 Поток: В линию для новостей или блога изображение и текст в списке

FD201 Поток: Сетка для новостей или блога изображение и текст в списке

FD301 Поток: Сетка для новостей или блога в одну, две, три или четыре колонки

FD302 Поток: Сетка для новостей или блога с фоном в одну, две, три или четыре колонки

FD401 Поток: Слайдер для новостей или блога

VD16 Виджет с видео фиксированная позиция в нижнем углу

BF901 Виджет для заказа обратного звонка на мобильном устройстве: вызывает функцию звонка

BF902N Виджет для отправки сообщения опционально: несколько полей для ввода

BF903 Виджет с формой подписки

BF904 Виджет с номером телефона

BF905 Виджет с мессенджерами

BF905A Виджет с мессенджерами cо всплывающими иконками вверх

T985 Виджет поиска по сайту, раскрывающийся по клику Иконку и положение виджета на странице можно изменить

T148 Поиск по сайту от Google

T133 JivoChat Виджет Вставка виджета от JivoChat

T138 Chatra Виджет Вставка виджета от Chatra.io

T152 Виджет TimePad

T151N Попап с виджетом TimePad Попап с виджетом от Таймпада

T790 Виджет Yclients для онлайн-записи

T884 Виджет Carrot Quest

T158 Disqus Comments

BF601 Typeform интегрирует формы с сервиса typeform.com

SM401 Popup: Facebook social plugin

T151N Popup: виджет TimePad Попап с виджетом от Таймпада

T868 Popup: HTML-код в попапе

T658 Предупреждение о возрастном ограничении

BF501N Popup: форма подписки

BF502N Popup: форма с множеством полей

BF503 Popup: information опционально: заголовок, описание, кнопки и кнопки «поделиться»

BF504 Popup: форма в углу экрана

SM402 Popup: VKontakte social plugin

VD09 Popup: Видео Youtube, Vimeo, .mp4 и другие

GL08N Popup: Галерея

ST500 Popup: карточка товара

ST505 Popup: карточка товара

ST510 Горизонтальный popup: карточка товара

T1093 Popup: Zero Block в попапе

T123 HTML-код

T868 Popup: HTML-код в попапе

T173 Якорная ссылка

T178 Плавный скролл до локальной якорной ссылки Модификатор

T143 Карта Google или Yandex

T198 Подсказка для ссылки

T193 Модификатор: стиль ссылок

T333 Индикатор прокрутки страницы

T228 Эффект загрузки страницы опционально: индикатор загрузки

T635 Эффект печатной машинки для заголовка

T674 Модификатор: добавление фонового изображения для всей страницы

T183 Триггер: Показывать поп-ап при скролле

T188 Триггер: Показывать поп-ап по таймеру

T723 Триггер: Показывать поп-ап при закрытии окна

T657 Уведомление об использовании куки

T886 Уведомление об использовании куки кнопка согласия справа

T887 Уведомление об использовании куки кнопка закрытия сверху справа

T972 Уведомление об использовании куки с возможностью выбора типа блокирует появление куки от счетчиков и пикселей до потверждения пользователем

T658 Предупреждение о возрастном ограничении

T223 Переадресация на URL

T203 Превращает страницу в презентацию Кнопки вверх/вниз, поддержка клавиатуры

T213 Alias-блок вставка блока с другой страницы без копирования

T208 Печать: разрыв страницы

T838 Поиск по сайту

T218 Системный комментарий Вставка простого html комментария

T803 Мультилендинг: динамический текст по параметрам в URL

T804 Геолендинг: динамический текст по геопозиции Меняет слова в зависимости от геопозиции посетителя

T805 Переадресация по языку Перенаправление посетителя на страницу с нужной языковой версией

T808 Переадресация по геопозиции Перенаправление на другой URL

T809 Мультилендинг: скрыть/показать блок по параметру в URL

T810 Геолендинг: скрыть/показать блок по Геопозиции Скрывает или показывает блоки в зависимости от геопозиции пользователя

T839 Мультилендинг: скрыть/показать блок по языку Скрывает или показывает блоки в зависимости от языка браузера посетителя

T826 Эффект галактики для обложек

T833 Анимированное слайдшоу для обложек этот модификатор добавит слайдшоу в обложки

T854 Канал новостей

T875 Защита контента от копирования

NY100 Новогоднее украшение еловые ветки и игрушки внизу экрана

NY110 Новогоднее сообщение изображение Санта Клауса или подарка внизу экрана с новогодним сообщением по клику

NY120 Падающие снежинки на обложке

NY130 Падающий снег на обложке добавляет эффект падающего снега в обложку

T1084 Модификатор: стиль скроллбара

T1093 Popup: Zero Block в попапе